전산회계 1급 합격 후기 및 공부 방법

IT전공자라 회계 지식이 없는 상태에서 회계/세무업무에 대해 관심을 가져 조사하던 중, 한국세무사회에서 주관하는 전산회계 1, 2급 및 전산세무 1, 2급에 대해 알게 되었습니다. 물론 유사 자격증들도 많아 취업을 위해서 같이 준비하는 것을 추천합니다.

사실, 자격증 2~3개는 별거 아닌 것처럼 보여도 자격증 5~7개를 취득하는 것은 면접관 입장에서 조금 다르지 않을까요? 사실 면접관분들은 30대 후반~40대 중반이 많으실 텐데, 다들 "현재의 능력" 보다는 "미래의 성장 가능성"을 더 우선시 하기에 노력하는 모습을 어필하는 것도 좋은 전략으로 생각됩니다.

- 전산회계 2급 : FAT 2급, 기업회계 3급, 회계관리 2급, 전산회계운용사 3급

-

전산회계 1급 : FAT 1급, 기업회계 3급, 회계관리 2급, 전산회계운용사 3급, ERP 정보관리사 회계 2급

-

전산세무 2급 : TAT 2급, 기업회계 2급, 세무회계 3급, 회계관리 1급, 전산회계운용사 2급, ERP 정보관리사 회계 1급

-

전산세무 1급 : TAT 1급, 기업회계 2급, 세무회계 2급, 재경관리사, 전산회계운용사 1급

# 공부 방법 #

난이도는 전산회계2급 < 전산회계 1급 < 전산세무 2급 < 전산세무 1급 순인데, 저는 전산회계 1급을 봤습니다. MASTER 라는 전산회계 1급 책을 구해서 읽어봤는데, 문장은 읽히지만 외울것도 많고 뭐가 중요한지 알 수가 없었습니다.

그래서 전략을 바꿔 "전산회계 1급 후기"를 검색하다 우연히 "박쌤 전산회계" 라는 카페와 그분의 유투브 강좌를 알게되었습니다. 그래서 책을 덮고, 유투브만 봤습니다. 유투브는 총 52개의 강좌(강좌별 20~30분 소요)였습니다. 박쌤께서 처음에 오리엔테이션 강좌가 1개 있는데, 반드시 들으세요. 학습방법과 소요시간을 설명해주는데, 본인이 회계기초가 부족하다면, 시험은 치지 않더라도 2급 강좌를 듣고 오는 것을 추천해서 2급 41개 강좌를 모두 듣고, 1급을 들었습니다.

책없이 유투브만으로 충분히 내용이 이해가 되었습니다.

이론 내용과 실무를 같이 설명해주시는데 충분했습니다. 책없이 2급을 보고 1급을 봤습니다. 1급과 2급은 수준(?)의 차이가 조금 있을 뿐 범위와 내용 차이가 적어 한번씩만 들으셔도 충분합니다.

속도는 1.5배로 했습니다. 사실 20분을 그대로 듣기에는 들어야할 강좌도 많고, 충분히 쉽게 설명해주셔서 가능했습니다. 책에서 어떤 것이 중요한지를 설명해주시니 뭘 봐야 할지 감이 잡혔습니다.

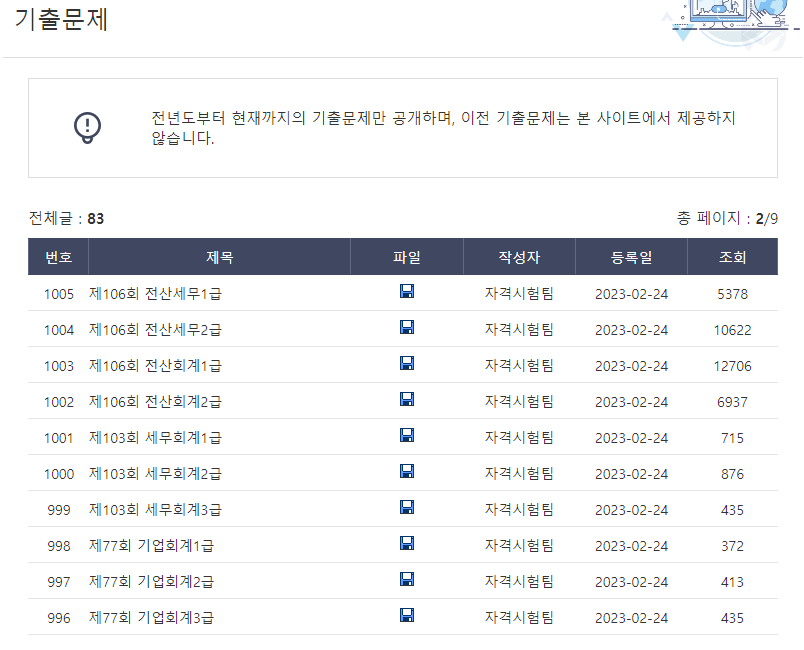

그 이후, 기출문제는 10회이상 프린트해서 이론 부분 모두 풀고, 모르는 것은 "박쌤 전산회계" 카페에 이론 설명하는 강좌가 있었는데, 틀린 문제중 설명이 필요한 문제만 문제풀이 영상을 봤습니다. 실기는 유형이 거의 90%동일합니다. 정말 처음 실기 문제를 풀 때는 거의 문제풀이 영상을 보고 따라하다가 3회부터는 슬슬 혼자 스스로 풀기 시작하고 5회부터는 단순한 것은 skip하고, 연습이 필요하다 싶은 문제만 발췌해서 풀었습니다.

시험칠 때, 정신없다.

생각보다 시간이 타이트했던 것 같습니다. 이론을 풀고 칠판의 시간을 보니 여유롭겠네..싶었지만, 실기를 하면서 생각보다 시간이 5분내외 정도만 남았었습니다. 시간이 여유롭지 않고 거의 딱! 맞다 정도입니다. 그래서 혹시 계산 문제가 잘 풀리지 않으시면 버리시고 풀 수 있는 문제에 최선을 다하십시요. 그래야 합격할 수 있습니다. 시험 종료 이후 1시간도 되지 않아 답안지가 나와서 가체점은 바로 나오는데 아마 유투브2급, 1급 강좌 + 기출문제 10회 정도로 준비하신 분이라면 합격하셨으리라 생각됩니다.

"박쌤 전산회계" 카페에는 2016년부터 매년 4~5회의 기출문제 + 문제풀이 영상이 있어서 최근 2년 정도만 준비하셔도 충분할 것 같습니다.

# 전산세무1급이 어려운 이유 #

강좌가 없다.

전산회계 1급을 취득한 후, 바로 전산세무 1급을 준비하였습니다. 사실 전산회계, 세무 모두 회계기초에서 부과세, 원가회계 등이 포함되면서 등급이 올라가는 것이라 이미 공부한게 머리에 있을 때 하는 게 좋기 때문입니다. 우선 유투브에서 강좌를 찾아봤는데, 없습니다...... 일부 1~3개 강좌가 오픈되어 있는 것은 봤지만 무료는 찾기 어려웠습니다. 몇 개 찾긴 했는데, 강의 방식이 저랑 맞지 않아서 듣다가 포기했습니다. (강좌별 50분정도 소요;;;)

중요한 것은 박쌤 전산회계 카페에는 전산세무 1급에 대한 강좌는 없습니다.

교제를 살까? 고민을 해봤습니다. 보통 교제를 사면 무료로 강좌를 들을 수 있기 때문입니다. 하지만 유투브에서 몇개 강좌를 본 이후, "방향을 제대로 못잡으면 생각보다 많은 시간이 걸릴 수도 있겠다" 생각했습니다. 왜 전산세무1급의 합격률이 10%미만인지 이해가 되었습니다.

그래서 전 강좌를 50%정도 듣다가 중도 포기했습니다. 이시간을 다른데 투자하는 게 현명하다고 판단했기 때문입니다. 그래도 후회하지 않습니다. 2급을 먼저 준비했으면 하는 아쉬움만 있을 뿐이었습니다.

전산세무1급이 꼭 필요한가?

회사에서 "전산세무 1급을 요구하나요?"

전산회계 1급이나 전산세무2급으로 충분하다면, 오히려 다른 것에 도전하는 것을 추천합니다. 후기들을 봐도 전산세무 1급을 요구하는 곳이 적다보니 교육시장이 작아 강좌들이 많지 않고, 그에 따라 "나에게 맞는 강좌 찾기가 어려운 것 같습니다."

# 요약 #

"박쌤 전산회계" 유투브 강좌 듣기 2급부터 1급(1.5배 속도)

"박쌤 전산회계" 카페에서 기출문제와 문제풀이 영상 발췌 보기

"전산세무 1급"은 꼭 필요한 경우가 아니라면 전산세무2급까지만 도전

'기출문제(수능, 자격증)' 카테고리의 다른 글

| 2024학년도 수능 기출 문제 및 답 (0) | 2023.12.05 |

|---|---|

| 2021학년도 수능 기출 문제 및 답 (0) | 2023.05.26 |

| 2022학년도 수능 기출 문제 및 답 (0) | 2023.05.26 |

| 2023학년도 수능 기출 문제 및 답 (0) | 2023.05.25 |